机构名称:

¥ 1.0

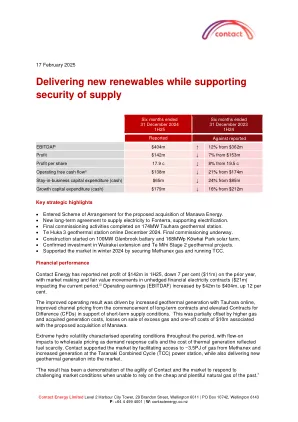

摘要。大型语言模型(LLMS)的进步已经开放了自然语言处理的新边界,尤其是在医疗保健等特殊领域。在本文中,我们提出了基于课程的微调(ICFT)框架,以增强医学大语言模型(MLLM)的发电能力。基于课程的学习,双阶段记忆协调和参数效果,以实现从一般语言知识到强大的领域特定专业知识的逐步过渡。跨不同医学NLP任务的实验结果,包括问题,偏好分类和响应产生,表明ICFT始终超过最先进的基准,从而提高了准确性和效率。进一步的分析揭示了该框架概括不见数据,减少错误并提供各种相关的医学响应的能力。这些发现将ICFT建立为适应LLM的强大和可扩展解决方案,以对现实世界中的医疗保健应用程序造成实际的利益。

arxiv:2502.00832v1 [CS.CL] 2025年2月2日

![arxiv:2502.00832v1 [CS.CL] 2025年2月2日PDF文件第1页](/bimg/a/a2276d6874930bcefb345c6fa0316b55edfda467.webp)

![arxiv:2502.00832v1 [CS.CL] 2025年2月2日PDF文件第2页](/bimg/b/bfeb7c555f6b53ca8920c454d51a559f1e504898.webp)

![arxiv:2502.00832v1 [CS.CL] 2025年2月2日PDF文件第3页](/bimg/e/e49d19c180e44f2681f907e53189caac602da9ff.webp)

![arxiv:2502.00832v1 [CS.CL] 2025年2月2日PDF文件第4页](/bimg/e/e27844465ca58146eb407e2364dd8db6cdd4d4b2.webp)

![arxiv:2502.00832v1 [CS.CL] 2025年2月2日PDF文件第5页](/bimg/0/0eb8bb9b7b13c58e31c1850afccbb69c1786237f.webp)

![arxiv:2502.00832v1 [CS.CL] 2025年2月2日](/simg/4/460750c88b2c2a3b4270f4bf1f9583392a580e2b.webp)

![arxiv:2502.12206v1 [CS.AI] 2025年2月16日](/simg/8/83a0040bd75286ed258ba3b033d6e887b6838904.webp)

![arxiv:2502.05739v1 [cs.cr] 2025年2月9日](/simg/8/8c90dfafcced8491bf122f9146142c704356b63d.webp)

![arxiv:2502.06651v1 [cs.cr] 2025年2月10日](/simg/8/85d07bd4f031075dcff413f6e20fae8b425df70c.webp)

![arxiv:2502.06956v1 [Quant-ph] 2025年2月10日](/simg/e/e5d48e0cf5320c7badff48c4e2d7683939a7f10c.webp)

![arxiv:2502.03124v1 [eess.sy] 2025年2月5日](/simg/3/33ae2427032dddacf611a2d02fbb8b420f4fa9fb.webp)

![arxiv:2502.04950v1 [Quant-ph] 2025年2月7日](/simg/6/62658c8c5932a77940998d5bbf5b5940842a4279.webp)

![arxiv:2502.08616v1 [physics.optics] 2025年2月12日](/simg/8/8f951540de4e0c49f787cb4d6e0dc9301842f228.webp)

![arxiv:2502.04250v1 [cond-mat.mes-hall] 2025年2月6日](/simg/e/e86f6a3cbfd2c80782d2669b3ef22eee55945349.webp)

![arxiv:2402.07016v1 [cs.ai] 2024年2月10日](/simg/9/9561106bbf3c742ff1228e38f3ed355eb69ea4a7.webp)